AI Act, pubblicate le Linee Guida sulle pratiche vietate approvate dalla Commissione europea

La Commissione europea ha pubblicato le Linee Guida sulle pratiche vietate in materia di Intelligenza Artificiale. Le Linee Guida presentano importanti vantaggi: esse forniscono spiegazioni, ma soprattutto esempi pratici per aiutare le parti interessate a comprendere e rispettare i requisiti dell’AI Act, per contribuire alla creazione di un panorama di IA sicuro ed etico.

AI Act: quali sono i sistemi di IA consentiti?

Il Regolamento europeo sull’intelligenza artificiale n. (EU) 2024/1689 (in seguito, “AI Act”), pubblicato il 13 giugno 2024 ed ufficialmente entrato in vigore il 1° agosto 2024, prevede norme armonizzate per l’immissione sul mercato europeo, la messa in servizio e l’uso dell’IA.

Il Regolamento mira a promuovere l’innovazione e l’adozione dell’IA, garantendo – al contempo – un elevato livello di protezione della salute, della sicurezza e dei diritti fondamentali dell’Unione e dei cittadini europei, ivi compresi la tutela della democrazia e dello Stato di diritto.

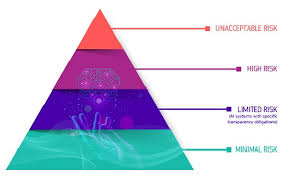

A tal fine, il Regolamento inaugura un approccio precauzionale, basato sul rischio (cd. risk – based approach), classificando i sistemi di IA in diverse categorie di rischio, tra cui quelli vietati, ad alto rischio e soggetti a obblighi di trasparenza.

In dettaglio, l’AI Act classifica i sistemi di IA in quattro differenti categorie di rischio:

| Rischio inaccettabile | Comprende i sistemi di IA che comportano rischi inaccettabili per i diritti fondamentali e i valori dell’Unione; tali sistemi sono esplicitamente vietati dall’articolo 5 dall’AI Act. |

| Rischio elevato | Riguarda sistemi di IA che presentano rischi elevati per la salute, la sicurezza e i diritti fondamentali. Questi sistemi sono classificati come «alto rischio» ai sensi dell’articolo 6 dell’AI Act, in combinato disposto con gli allegati I e III; tali sistemi sono soggetti ad una serie di requisiti e obblighi. |

| Rischio di trasparenza | Comprende quei sistemi di IA che presentano un rischio di trasparenza limitato, e pertanto soggiacciono agli obblighi di trasparenza secondo l’articolo 50. |

| Rischio minimo o nullo | La categoria riguarda quei sistemi di IA che presentano un rischio minimo o nullo e pertanto non necessitano una regolamentazione; ciononostante, i fornitori e gli operatori possono aderire volontariamente a codici di condotta, ai sensi dell’articolo 95. |

Nell’ambito delle categorie di rischio, i sistemi di IA aventi rischio inaccettabile rappresentano certamente quelle più pericolose.

Per tali ragioni, l’attenzione del legislatore si è dapprima concentrata su questa categoria, prevedendo l’intervento della Commissione europea, ad integrazione del dettato normativo, per fornire dettagli su quali pratiche dovessero ritenersi vietate.

Com’è noto, infatti, ai sensi dell’articolo 96, paragrafo 1, lettera b), dell’AI Act, la Commissione europea è tenuta a adottare orientamenti operativi sulle pratiche vietate ai sensi dell’articolo 5.

L’articolo 5, comma 1, enuclea le pratiche vietate, divieti che sono entrati pienamente in vigore lo scorso 2 febbraio 2025, ossia sei mesi dopo l’entrata in vigore dell’AI Act:

- l’immissione sul mercato, la messa in servizio o l’uso di un sistema di IA che utilizza tecniche subliminali che agiscono senza che una persona ne sia consapevole o tecniche volutamente manipolative o ingannevoli aventi lo scopo o l’effetto di distorcere materialmente il comportamento di una persona o di un gruppo di persone, pregiudicando in modo considerevole la loro capacità di prendere una decisione informata, inducendole pertanto a prendere una decisione che non avrebbero altrimenti preso, in un modo che provochi o possa ragionevolmente provocare a tale persona, a un’altra persona o a un gruppo di persone un danno significativo;

- l’immissione sul mercato, la messa in servizio o l’uso di un sistema di IA che sfrutta le vulnerabilità di una persona fisica o di uno specifico gruppo di persone, dovute all’età, alla disabilità o a una specifica situazione sociale o economica, con l’obiettivo o l’effetto di distorcere materialmente il comportamento di tale persona o di una persona che appartiene a tale gruppo in un modo che provochi o possa ragionevolmente provocare a tale persona o a un’altra persona un danno significativo;

- l’immissione sul mercato, la messa in servizio o l’uso di sistemi di IAper la valutazione o la classificazione delle persone fisiche o di gruppi di persone per un determinato periodo di tempo sulla base del loro comportamento sociale o di caratteristiche personali o della personalità note, inferite o previste, in cui il punteggio sociale così ottenuto comporti il verificarsi di uno o di entrambi gli scenari seguenti:

- un trattamento pregiudizievole o sfavorevole di determinate persone fisiche o di gruppi di persone in contesti sociali che non sono collegati ai contesti in cui i dati sono stati originariamente generati o raccolti;

- un trattamento pregiudizievole o sfavorevole di determinate persone fisiche o di gruppi di persone che sia ingiustificato o sproporzionato rispetto al loro comportamento sociale o alla sua gravità;

- l’immissione sul mercato, la messa in servizio per tale finalità specifica o l’uso di un sistema di IA per effettuare valutazioni del rischio relative a persone fisiche al fine di valutare o prevedere il rischio che una persona fisica commetta un reato, unicamente sulla base della profilazione di una persona fisica o della valutazione dei tratti e delle caratteristiche della personalità; tale divieto non si applica ai sistemi di IA utilizzati a sostegno della valutazione umana del coinvolgimento di una persona in un’attività criminosa, che si basa già su fatti oggettivi e verificabili direttamente connessi a un’attività criminosa;

- l’immissione sul mercato, la messa in servizio per tale finalità specifica o l’uso di sistemi di IA che creano o ampliano le banche dati di riconoscimento facciale mediante scraping non mirato di immagini facciali da internet o da filmati di telecamere a circuito chiuso;

- l’immissione sul mercato, la messa in servizio per tale finalità specifica o l’uso di sistemi di IA per inferire le emozioni di una persona fisica nell’ambito del luogo di lavoro e degli istituti di istruzione, tranne laddove l’uso del sistema di IA sia destinato a essere messo in funzione o immesso sul mercato per motivi medici o di sicurezza;

- l’immissione sul mercato, la messa in servizio per tale finalità specifica o l’uso di sistemi di categorizzazione biometrica che classificano individualmente le persone fisiche sulla base dei loro dati biometrici per trarre deduzioni o inferenze in merito a razza, opinioni politiche, appartenenza sindacale, convinzioni religiose o filosofiche, vita sessuale o orientamento sessuale; tale divieto non riguarda l’etichettatura o il filtraggio di set di dati biometrici acquisiti legalmente, come le immagini, sulla base di dati biometrici o della categorizzazione di dati biometrici nel settore delle attività di contrasto;

- l’uso di sistemi di identificazione biometrica remota «in tempo reale» in spazi accessibili al pubblico a fini di attività di contrasto a meno che, e nella misura in cui, tale uso sia strettamente necessario per uno degli obiettivi seguenti:

- la ricerca mirata di specifiche vittime di sottrazione, tratta di esseri umani o sfruttamento sessuale di esseri umani, nonché la ricerca di persone scomparse;

- la prevenzione di una minaccia specifica, sostanziale e imminente per la vita o l’incolumità fisica delle persone fisiche o di una minaccia reale e attuale o reale e prevedibile di un attacco terroristico;

- la localizzazione o l’identificazione di una persona sospettata di aver commesso un reato, ai fini dello svolgimento di un’indagine penale, o dell’esercizio di un’azione penale o dell’esecuzione di una sanzione penale per i reati di cui all’allegato II, punibile nello Stato membro interessato con una pena o una misura di sicurezza privativa della libertà della durata massima di almeno quattro anni.

Qual è l’ambito di applicazione delle Linee Guida?

Le linee guida mirano a garantire l’applicazione coerente, efficace e uniforme dell’AI Act in tutta l’Unione europea.

Nonostante le Linee Guida forniscono preziosi dettagli interpretativi dei divieti da parte della Commissione, esse non costituiscono atti vincolanti, considerate peraltro le competenze riservate alla Corte di giustizia dell’Unione europea (CGUE) per garantire l’uniforme applicazione ed interpretazione della normativa europea.

In ogni caso, le Linee Guida presentano importanti vantaggi: esse forniscono spiegazioni, ma soprattutto esempi pratici per aiutare le parti interessate a comprendere e rispettare i requisiti dell’AI Act, per contribuire alla creazione di un panorama di IA sicuro ed etico.

L’applicazione dell’articolo 5 della legge sull’AI richiederà una valutazione caso per caso, tenendo debitamente conto della situazione specifica. Pertanto, gli esempi forniti nelle Linee Guida sono meramente indicativi e non pregiudicano la necessità di tale valutazione in ciascun caso.

Nel complesso, le linee guida forniscono una panoramica ampia sull’ambito applicativo (oggettivo e soggettivo) dell’AI Act, soffermandosi su una serie di pratiche vietate menzionate all’articolo 5, paragrafo 1, come la manipolazione dannosa, il punteggio sociale e l’identificazione biometrica remota in tempo reale.

Pertanto, le Linee Guida si soffermano:

- Pratiche vietate ai sensi dell’articolo 5, paragrafo 1, lett.e): attività di scraping non mirato di immagini facciali da internet o da filmati di telecamere a circuito chiuso;

- Pratiche vietate ai sensi dell’articolo 5, paragrafo 1, lett.f): attività di tracking e di riconoscimento delle emozioni;

- Pratiche vietate ai sensi dell’articolo 5, paragrafo 1, lett.g): sistemi di categorizzazione biometrica che classificano individualmente le persone fisiche sulla base dei loro dati biometrici per trarre deduzioni o inferenze in merito a particolari categorie di dati personali;

- Pratiche vietate ai sensi dell’articolo 5, paragrafo 1, lett.h): sistemi di identificazione biometrica remota «in tempo reale» per la realizzazione di obiettivi di cd. “Law Enforcement”.

Quanto all’ambito di applicazione soggettivo, l’AI Act distingue tra diverse categorie di operatori in relazione ai differenti sistemi regolati. In particolare, il Regolamento distingue e definisce all’articolo 3:

- Il «fornitore»: una persona fisica o giuridica, un’autorità pubblica, un’agenzia o un altro organismo che sviluppa un sistema di IA o un modello di IA per finalità generali o che fa sviluppare un sistema di IA o un modello di IA per finalità generali e immette tale sistema o modello sul mercato o mette in servizio il sistema di IA con il proprio nome o marchio, a titolo oneroso o gratuito;

- «deployer»: una persona fisica o giuridica, un’autorità pubblica, un’agenzia o un altro organismo che utilizza un sistema di IA sotto la propria autorità, tranne nel caso in cui il sistema di IA sia utilizzato nel corso di un’attività personale non professionale;

- «rappresentante autorizzato»: una persona fisica o giuridica ubicata o stabilita nell’Unione che ha ricevuto e accettato un mandato scritto da un fornitore di un sistema di IA o di un modello di IA per finalità generali al fine, rispettivamente, di adempiere ed eseguire per suo conto gli obblighi e le procedure stabiliti dal presente regolamento;

- «importatore»: una persona fisica o giuridica ubicata o stabilita nell’Unione che immette sul mercato un sistema di IA recante il nome o il marchio di una persona fisica o giuridica stabilita in un paese terzo;

- «distributore»: una persona fisica o giuridica nella catena di approvvigionamento, diversa dal fornitore o dall’importatore, che mette a disposizione un sistema di IA sul mercato dell’Unione;

- «operatore»: un fornitore, un fabbricante del prodotto, un deployer, un rappresentante autorizzato, un importatore o un distributore.

Come precisato dalla Commissione europea, le Linee Guida si concentreranno solo sui fornitori e sui deployer, ai sensi dell’articolo 3, paragrafo 1, n.3)e 4).

Di Alessia Palladino

Assegnista di ricerca e Cultore della Materia in «Informatica giuridica» e «Computer Law» presso l’Università degli Studi di Cagliari